|

|

Ny Generation af Grafikkort. |

Besvar

|

Side <1 2526272829 35> |

| Forfatter | |||||||

TBC1

Guld medlem

Oprettet: 19-Februar-2009 Status: Offline Point: 2053 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 21-September-2022 kl. 01:34 Sendt: 21-September-2022 kl. 01:34 |

||||||

|

Så er RTX 4070, 80 & 90 officielt afslørede. 4000 serien er bedre end selv de bedste forventninger: op til 2 x Raster performance (forventet) og op fra over 2 til 4 x performance i Raytracede og AI accelererede titler (langt bedre end forventet) - Der er nye teknologier til accelerationen af Raytracing der for alvor muliggør at lave spil med og spille disse ved meget høje Raytracing settings, men det er måske ikke mindst DLSS 3.0 (som kun RTX 4000 serien lader til at få, med den nye hurtigere tensor core generation) der kommer ind fra siden som en BOMBE og VIRKELIG sparker røv på den nye arkitektur. Så det bliver det den mest spændende generation med et af de absolut største generationsspring man har set længe! ...Jeg skal helt sikkert selv ud og have fat i et 4090 d. 12/oktober - nu skal jeg bare lige ud og finde ud af hvilket.

Her er ind til videre nogle links at gøre godt med: MUST SEE!!!: https://youtu.be/qyGWFI1cuZQ - Digital Foundry trailer for kommende analyser, der afslører en hel del om performance! og de andre: Nvidia's egen reklame: https://youtu.be/fj245xMr-BM (Jeg bemærker mig at det også får AV1 encoding) AIB-relaterede: NVIDIA GeForce RTX 4090, RTX 4080 16 GB & RTX 4080 12 GB Custom Models Roundup (wccftech.com) NVIDIA GeForce 40 Graphics Series | VideoCardz.com (anno 21-09.2022) - Der kan man se flere forskellige og læse pressemeddelelserne om dem. MSI GeForce RTX 40 Series Graphics Card | APEX EVOLUTION - Supreme og Gaming må forventes at få nogle spændende versioner - MSI havde nogle af de absolut bedste AIB kort mht til den sidste generations launch modeller. Ascend to new heights with the new GeForce RTX 4090 and RTX 4080 cards from ROG Strix and TUF Gaming | ROG - Republic of Gamers USA (asus.com) og https://youtu.be/qqA7fgQwg4g - TUF ser umiddelbart lidt skuffende ud denne gang (standard 450W og skrumpet størrelse for at passe i flere kabinetter, men Rog Strix (500W) ser til gengæld spændende ud og Asus's vapor chamber er top notch. AORUS GeForce RTX® 40 Series Graphics Cards | AORUS og https://youtu.be/nBSjuUYLAX0 Gigabyte's AORUS Master ser også meget spændende ud - Det får hvad der umiddelbart ser ud til at være den vildelste kølerprofil af dem jeg endnu har set (af billederne at bedømme) + det har vapor chamber. Bliver det over 500W? Eller kan det være den grænse Nvidia har sat som "tilladt" for AIB kortene, for at sikre sig rum på flere dimensioner til en senere TI model? (I lyset af at Asus Rog jo "kun" er 500W) _____ Dem har jeg ikke nået at sætte mig ind i overhovedet endnu - og sengen kalder, men her er links: Introducing RTX 40 series (galax.com) og https://youtu.be/nG2waSsYyYQ ZOTAC GAMING Announces the GeForce RTX 40 Series Powered by the Next Generation GPU Architecture | ZOTAC PNY Introduces Next Evolution NVIDIA GeForce RTX 40 Series GPU’s-PNY Gainward Releases GeForce RTX® 4090, RTX® 4080 16 GB & 12 GB Series og https://youtu.be/PgabH0I4XIA Palit Announces GeForce RTX® 40 - GameRock and GamingPro Series og https://youtu.be/9PmGHwllB90 Hvad jeg kan finde at brokke mig over er at RTX 4080 12 GB burde have heddet RTX 3070 og at prissætningen på 80 serien er svært at sluge i forhold til sidst. Men det handler formentligt om at der stadig skal sælges en del 3000 serie kort og det ville formentligt blive sværere hvis et billigere hvis 4070 og 4060 kom ud nu, særligt i betragtning af DLSS 3.0 så de virkelig jordede de 3000 serie kort der også skal fyres af. Redigeret af TBC1 - 25-September-2022 kl. 11:30 |

|||||||

|

PC:9800X3D,RTX 5090 OC,32GB DDR5@6K-CL30,48" LG CX

Stue:JVC N7,StudioTek 130,Denon AVR4308,Bladelius Ymer,B&W 803D,SVS PB16-Ultra,DMR-UBC80,Shield 2019 Sovevær.:77" S92C,HTP-075,ATV4K |

|||||||

|

|||||||

jake51

Guld medlem

Oprettet: 02-Januar-2005 Sted: Randers Status: Offline Point: 6492 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 21-September-2022 kl. 07:29 Sendt: 21-September-2022 kl. 07:29 |

||||||

Hvad siger banken til det

|

|||||||

|

Vi started' ud med ingenting og har det meste tilbage

Mikael Simpson |

|||||||

|

|||||||

Emilos88

Guld medlem

Oprettet: 01-April-2008 Sted: Denmark Status: Offline Point: 925 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 21-September-2022 kl. 11:35 Sendt: 21-September-2022 kl. 11:35 |

||||||

|

Hvad siger elregningen til det

Det virker som et godt spring, og bestemt spændende. Jeg tror jeg lever med mit 2080 lidt endnu, synes ikke jeg mangler noget. Men hvis man kan hente meget på VR med de nye kommende headset, så kan jeg ændre mening

|

|||||||

|

Get HIFI or die trying c",

|

|||||||

|

|||||||

kec2

Super bruger

Oprettet: 27-Oktober-2009 Sted: Denmark Status: Offline Point: 354 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 21-September-2022 kl. 13:16 Sendt: 21-September-2022 kl. 13:16 |

||||||

|

El er billigere end gas, så jeg bruger min gaming pc som radiator. 🤣🤣

Jeg har snakket med naboer som følger sig udskammet pga. julebelysning. Hvorfor gør vi det mod hinanden? Det er også et problem hvis alle spare. 4090 = $1200 == 12.000,- av av. ☹️ 1080ti er for små til 4k. Jeg skulle have købt en skærm med lavere opløsning. 😡

|

|||||||

|

Der findes 10 slags mennesker. Dem der kan det binærer talsystem og dem der ikke kan.

|

|||||||

|

|||||||

jake51

Guld medlem

Oprettet: 02-Januar-2005 Sted: Randers Status: Offline Point: 6492 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 21-September-2022 kl. 15:38 Sendt: 21-September-2022 kl. 15:38 |

||||||

|

Jeg venter spændt på, at MM Vision begynder at sælge stationære med RTX 4070/4080

Så må vi se, hvad det koster

|

|||||||

|

Vi started' ud med ingenting og har det meste tilbage

Mikael Simpson |

|||||||

|

|||||||

TBC1

Guld medlem

Oprettet: 19-Februar-2009 Status: Offline Point: 2053 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 21-September-2022 kl. 18:09 Sendt: 21-September-2022 kl. 18:09 |

||||||

Ikke noget. Coronakrisen har været god for min økonomi. Ikke så god at der er til en 140 tommer MicroLED installation, men rigeligt til at prioritere en af de ting jeg bruger allermest - Og pengene står jo ikke ligefrem og bliver mere værd på kontoen for tiden, men den inflation vi har om ørerne.

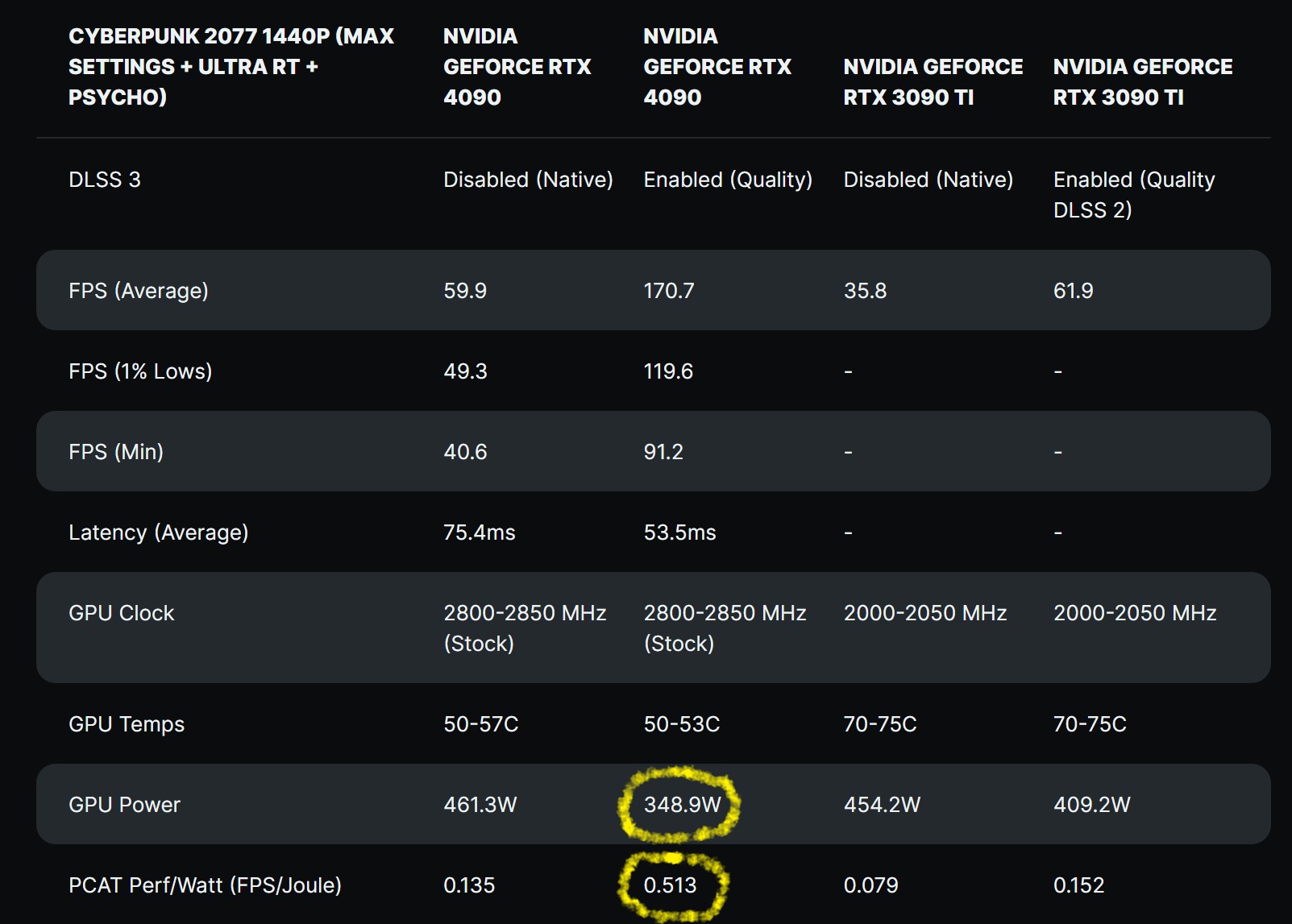

Den skånes faktisk ved titler hvor mit eksisterende RTX 3080 i forvejen kan ramme de 120 fps, formentligt allerede fra omkring titler, hvor mit RTX 3080 rammer >60, da min skærm er max 120 fps. For 4000 serien er med TSMC's node MARKANT mere energiefftektiv end forrige generationer, så meget mere effektiv at de nye 4080'ere får LAVERE energiforbrug end de forrige 3080 kort og samtidig den dobbelte ydelse. På titler hvor der skal tages en del kraftigere fat end mit nuværende RTX 3080 kan præstere til, kan RTX 4090 naturligvis også tage ekstra fat med et højere energiforbrug, ved den langt højere ydelse det kan nå end mit nuværende RTX 3080 - Jævnfør: https://cdn.neow.in/news/images/uploaded/2022/09/1663687645_screenshot_(405).jpg Edit 23/09 2022: Der er i mellemtiden dukket denne opgørelse op på wccftech, som understreger ovenstående pointe. Den nye generation bruger omtrent det samme strøm til at lave "op til" dobbelt framerate på samme render uden AI brug og bruger ligefrem MINDRE strøm på at generere 170,7 fps end den forrige generation brugte på at lave 61,9 fps med AI:  kilde: https://wccftech.com/nvidia-geforce-rtx-4090-runs-up-to-2850-mhz-at-stock-50c-temps-in-cyberpunk-2077-dlss-3-cuts-gpu-wattage-by-25-percent/ kilde: https://wccftech.com/nvidia-geforce-rtx-4090-runs-up-to-2850-mhz-at-stock-50c-temps-in-cyberpunk-2077-dlss-3-cuts-gpu-wattage-by-25-percent/

Det man nok først og fremmest kan hente til VR er understøttelse af højere opløste headset og/eller større grader af supersampling til støre visuel kvalitet.

🤣

FE bliver vist 14.990 i Danske kr iflg Nvidia.dk - Så mon ikke jeg skal af med ~17.500 kr for det AIB med ekstra juice og power jeg kommer til at gå efter? ...Jeg kommer så i øvrigt til at lægge ud for lillebror også, der jo ikke kan tåle at se så stort et generationsspring gå hans næse forbi, selv om han aktuelt må koncentrere sig om at betale sine stigende regninger i øvrigt. Redigeret af TBC1 - 23-September-2022 kl. 14:33 |

|||||||

|

PC:9800X3D,RTX 5090 OC,32GB DDR5@6K-CL30,48" LG CX

Stue:JVC N7,StudioTek 130,Denon AVR4308,Bladelius Ymer,B&W 803D,SVS PB16-Ultra,DMR-UBC80,Shield 2019 Sovevær.:77" S92C,HTP-075,ATV4K |

|||||||

|

|||||||

ASKF

Super bruger

Oprettet: 24-Oktober-2015 Sted: Ålborg, DK Status: Offline Point: 293 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 22-September-2022 kl. 04:07 Sendt: 22-September-2022 kl. 04:07 |

||||||

De kunne også have valgt at kalde RTX 4080 16 GB for "Super", da der jo er planlagt et 4070 kort. En anden årsag til den høje pris, skyldes nok at Nvidia har erfaret at kortene kan sælges til meget høje priser, så hvorfor ikke udnytte dette, når hovedkonkurrenten ikke kan følge med pt. Vi må håbe at AMD snart kan følge med igen, så vi kan få noget reel konkurrence og dermed lavere priser. NB. Jeg har ikke benyttet AMDs kort siden jeg købte et GTX 970, fordi jeg var blevet træt af dårlige driver og UI fra AMD. Er dette blevet bedre i de mellemliggende år?

|

|||||||

|

|||||||

TBC1

Guld medlem

Oprettet: 19-Februar-2009 Status: Offline Point: 2053 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 22-September-2022 kl. 10:15 Sendt: 22-September-2022 kl. 10:15 |

||||||

) )Sammenhængen er den, at den måde man "sorterer" modellerne på er meget anderledes denne gang. Både 3090 og 3080 var sidste gang baseret på den største GPU i 3000 serien (GA102), hvor 3090 benyttede 97,6% og 3080 et 81% af den fulde GA102 chip (den fulde chip udkom ultimativt som et 3090 Ti). Denne gang udnytter 4090 89% af AD102. Men end ikke 4080 16 GB er denne gang bygget på AD102, men på AD103 og RTX 4080 12 GB er bygget på AD104, svarende til det at et RTX 3070 sidst var bygget på GA104. De 2 4080 modeller er med andre ord 2 HELT forskellige grafikkort denne gang med forskellige GPU konfigurationer og forskellige clocks mv. Så det er imho noget rod at de begge hedder 4080, da det på ingen måde er 2 forskellige versioner af samme kort, bare med forskellige ram konfigurationer som folk hurtigt kunne forledes til at tro - Det er to helt forskellige grafikkort!

...Det er jo helt vildt og helt vendt på hovedet! ...Det er jo helt vildt og helt vendt på hovedet!Lad mig bare sige det sådan at jeg er blot blevet YDERLIGERE bestyrket i mit valg om at købe 90'er modellen denne gang, ikke alene på den meget større ydelsesforskel på 80 og 90 modellerne denne gang, men også med den prisstrategi Nvidia har lagt denne gang. Sidst var det helt omvendt endog MEGET svært at retfærddiggøre den den gang dobbelte pris for et 3090 over et 3080, da forskellen da var MARKANT mindre på 80 og 90 modellen end den bliver denne gang. 4090 købere kan fra de sidste år som baseline svært være andet en godt tilfredse. - inflation og det hele i betragtning ligger de prismæssigt mere eller mindre uændret fra sidst og relativt set meget mere lunt i svinget, mens dem der har sigtet efter 3080 tier denne gang aktuelt bliver tørret i røven i 2 forskellige helt forkerte retninger, både mht. ydelsesindplacering og pris i forhold til sidst. Når 3000 kortene engang er blevet fyret af, så er der dog stort potentiale i AD102 chippen med modeller både over (4090 Ti) og under for den sags skyld (måske som et 4080 Ti der for alvor kommer til at sparke røv ifht de øvrige 4080'ere?) og AD104 og AD106 kan blive til de kendte billigmodeller til massemarkedet Arkitekturen fejler i hvert fald ikke noget - Den udgør et af de største generationsspring vi længe har set, oven i det så endog yderligere forstærket af DLSS 3 som ekstra turbo-charger over AMD og Nvidia's egen 3000 serie. ( https://youtu.be/aw4oPbnzpkM  ) ...Men prissætningen og udgivelsesstrategien mht til lige "3080" kortene, den kan man i hvert fald godt med god grund kritisere! ) ...Men prissætningen og udgivelsesstrategien mht til lige "3080" kortene, den kan man i hvert fald godt med god grund kritisere!______________________________________________________________________________ Oversigt over de forskellige AIB kort, med data som de efterhånden dukker op (sort ikke grå tekst) kan findes her: NVIDIA GeForce RTX 4090 Specs | TechPowerUp GPU Database Redigeret af TBC1 - 25-September-2022 kl. 17:15 |

|||||||

|

PC:9800X3D,RTX 5090 OC,32GB DDR5@6K-CL30,48" LG CX

Stue:JVC N7,StudioTek 130,Denon AVR4308,Bladelius Ymer,B&W 803D,SVS PB16-Ultra,DMR-UBC80,Shield 2019 Sovevær.:77" S92C,HTP-075,ATV4K |

|||||||

|

|||||||

Lort

Ny bruger

Oprettet: 26-September-2022 Status: Offline Point: 8 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 26-September-2022 kl. 11:00 Sendt: 26-September-2022 kl. 11:00 |

||||||

|

4080 12GB er med sikkerhed ikke noget decideret dårligt kort, men det burde have heddet 4070 eller 4070 Ti. Jeg håber personligt aldrig de trækker SUPER betegnelsen frem igen...

4070 bliver et cut down af AD103 som 4080/12GB bruger. 4080/12GB bruger den fulde AD104 chip. Spørgsmålet bliver hvor meget. De kan også sænke bussen til 160 bit og kun smide 10GB VRAM på og det ville ikke undre mig hvis de gør præcis det. 4090 kommer nok til at koste 16000-18000 DKK og det vil jeg aldrig betale for en GPU, slet ikke en som suger ~500 watt. Jeg købte 3080 på release til 5600 DKK og jeg købte også et 3070 til 4300 DKK da det udkom. Skifter GPU hvert 2-3 år, så jeg gider slet ikke overveje dem som koster over 10.000, da de bliver slået 2 år senere af et kort til det halve og ikke når at komme til sin ret alligevel. Men betaler kassen for VRAM som aldrig kommer i brug. Selv med 3090 rammer man nærmest aldrig over 10GB forbrug i spil, i 4K/UHD og når spil faktisk kan bruge 24GB, så er chippen alt for sløv og man er nødt til at sænke detaljerne alligevel. Jeg er sikker på at priserne nok skal falde når de har fået skudt 3080 Ti / 3090 og 3090 Ti af. Der er slet ikke den samme mangel på grafikkort som der var for 6-12-18 måneder siden. Jeg har dog ikke de store forventninger til AMDs Radeon 7000 serie bliver meget billigere, for tror det er TSMC der presser prisen i vejret hos dem begge. I hvert fald indtil videre. For Apple bruger stadig deres 4nm process rigtigt meget og der er rift om den. Apple vil altid have førsteprioritet hos TSMC. Det virker også til at Ada Lovelace / RTX 4000 serien ikke engang har DP 2.0, men stadig 1.4a hvilket er sølle hvis det passer... Standarden kom på plads i 2019. Det er også allerede nu kendt at Ada Lovelace på ingen måde er 2-4 bedre end Ampere i helt almindelige spil. Det er i håndplukkede spil, med brug af RT på højeste indstilling OG med DLSS 3.0 aktiveret. Et underligt sammenligningsgrundlag. Men det lød jo godt at sige i deres launch event. 3000 til 4000 bliver på ingen måde et kæmpe spring i helt alm. rasterization performance, altså uden RT og uden brug af DLSS 3.0. Måske nærmere 60-75% fra 3090 Ti til 4090 men prisen er også steget 50-60%. 4090 er 78% hurtigere end 3090 i 3DMark, så spilydelsen er nok omkring de 60-75% da 3Dmark altid skalerer bedre. Det er vildt at Nvidia brugte DLSS 3.0 i deres claims, da et meget lille antal spil vil have det og kvaliteten af implementeringen svinger fra meget spil til spil. 3090 til 4090 bliver stadig et okay spring men 3090 kostede 12K da det udkom, og 4090 vil nærmere koste 16-18K. 4090 får ikke engang 23 Gbps GDDR6X som 4080/16GB bruger, men de billigere 21 Gbps moduler som 4080/12GB også bruger. Ret tamt at "topkortet" får billigere ram. I kan være helt sikre på at 4090 Ti lander med den fulde chip og 23 Gbps ram om et års tid. Sikkert til en lavere pris end 4090 koster på udgivelsen, da priserne nok skal falde over de næste 6-9 måneder. Håber meget at AMDs løsninger er bare nogenlunde. De vil benytte MCM denne gang og tegner til at slå Nvidia nemt på ydelse per watt af denne grund. Nvidia satser stadig på monolithic og vil nok første med 5000 serien gå MCM. Rygter lyder på at Radeon 7000 vil nærme sig 4 GHz clockspeeds. Kan være jeg samler et 4080/16GB op om 6-12 måneder, afhænger af om prisen falder. Mit 3080 kører stadig alt til perfektion så kan alligevel ikke retfærdiggøre det nu. Kan også være det bliver et AMD kort næste gang, hvis de kommer med noget godt. Jeg gider dog slet ikke overveje GPUer som bruger mere end 350-400 watt. De frigiver alt for meget varme i rummet. Mit 3080 bruger omkring 325 watt med undervolt + overclock til ca. 2.1 GHz i spil og det kan mærkes på en varm sommerdag... Så 450-500 watt med 4090 og nok måske 550-600 watt med 4090 Ti? Nej tak herfra og ikke kun pga. prisen på selve kortene. 4090 bruger som stock 450 watt. Det bruger kun mindre når man er begrænset af andet, og GPU usage ikke er på 100%. F.eks. ved brug af DLSS 3.0, som i det Cyberpunk test længere oppe. Det ændrer ikke på at kortet i sig selv, er en 450 watt løsning. Det er det opgivet til fra Nvidias side. Bare kig på wattforbruget uden DLSS 3.0 aktivt og det ligger på 462 watt for et STOCK 4090. Vi vil helt sikkert se custom kort trække både 500 og 550 watt når de er maxet ud. TBC1; Jeg håber da ikke du bruger en 7700K til det 4090 for så vil du blive kraftigt begrænset. Du burde som minimum være på Ryzen 5000 el. Alder Lake med 32GB DDR5 med høj clock og lave timings. Men nu er Ryzen 7000 og 13. generation Raptor Lake lige på trapperne. Jeg kører selv en i7-12700K ved 5.4 GHz sammen med mit RTX 3080 og 32GB DDR5 ved 6000/CL32. Gav et pænt boost fra min gamle i9-9900K ved 5 GHz på alle kerner, som er markant hurtigere end 7700K. Mange spil i dag har heller ikke nok i 4C/8T, men kører meget bedre med 6C/12T eller bedre. Meget højere minimum fps.

Redigeret af Lort - 26-September-2022 kl. 14:08 |

|||||||

|

|||||||

TBC1

Guld medlem

Oprettet: 19-Februar-2009 Status: Offline Point: 2053 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 26-September-2022 kl. 15:47 Sendt: 26-September-2022 kl. 15:47 |

||||||

Og så mener jeg, at fra bruger perspektiv, bør man jo ikke glemme at dér hvor man for alvor får brug for et nyt kort, hvis man f.eks. har f.eks. et eksisterende RTX 3090 Ti, eller bare vores 3080'ere, jo IKKE ligefrem er i gamle raztorization titler hvor man i forvejen måske kan få omkring hundrede frames i 4K eller mere i lavere opløsninger, men at det jo netop til de tunge mere komplekse titler i høj opløsning med de helt tunge Raytracing setting hvor ens aktuelle GPU ikke er kraftig nok. Så i mine øjne giver det hele absolut god mening. Spiller man kun rasterization-only titler, så behøver man som udgangspunkt mindre hvad noget så meget som et 4090 tilbyder. Jeg har f.eks. selv udskudt at spille CyberPunk 2077 og andre RayTracede titler, i erkendelsen af at det efter mine krævende præferencer ikke var RTX-3000 serien der kom til at tillade mig at spille det som jeg ønskede det. Der har jeg f.eks. ventet til der kom en generation hurtigt nok til at tilfredsstille mine præferencer. Jeg var faktisk i tvivl om det så blev 4000 serien eller først næste igen jeg kom til at spille Cyberpunkt 2077, men alt tyder på at Raytracing er prioriteret så højt i den nye arkitektur, men særligt vægt på ekstra accelleration af disse aspekter, hvor de nuværende generationer kommer til kort, hvilket de jo reelt ikke rigtigt gør på rasterization-only titler.

Jeg har 4K skærm og sigter efter spillenes højeste grafiske settings. Jeg har aldrig haft en GPU der har været så meget som bare i nærheden af at skalere med min CPU ved 4K. Med det 3080 jeg har i dag udnyttes alt efter spillet gerne 5-33% af min CPU, når min GPU udnyttes 100%. Naturligvis handler det også om hvilken type spil man spiller og den opløsning og de grafiske settings man gør det med (for mit vedkommende sigtes der efter max hvis GPU'en ellers kan være med på det). Og der har jeg altså selv endnu til gode overhovedet at spille et spil hvor det er min CPU og ikke min GPU der er den helt store flaskehalsen. Jeg er med på at jeg lever på lånt tid, men jeg forestiller mig faktisk at RTX 4090 kommer til at skalere direkte bedre til min CPU end 3080 nogen sinde har gjort det (Til 4K highest quality settings vel at mærke!). Og DLSS 3 kommer faktisk til at udvide rummet der er at gøre godt med, for den dertil benyttede teknologi kommer til at flytte yderligere workload til GPU i den forstand at man med DLSS 3 understøttede spil kommer til at kunne få flere frames end CPU'en overhovedet kan være medvirkende til i forbindelse med et render i den givne kæde - Så der bliver sandsynligvis ekstra CPU liv at hente der, men ja, jeg er med på at det er på lånt tid. Dine erfaringer i forhold til mine egne fortæller mig så at du enten spiller helt andre typer spil end jeg og/eller har en skærm med lavere opløsning, og sikkert også samtidig med højere refresh rate end min 120 fps 4K skærm - Og man indretter sig naturligvis altid efter den kæde man har - Så min egen plan er denne: Køb RTX 4090, erfarer hvordan den skalerer til CPU'en i de spil jeg spiller. Hvis det skulle vise sig at det pludselig er CPU der går hen og bliver bottleneck og 4090 ikke kan udnyttes til mindst 90-100% ELLER til skærmens 120 fps, med de settings og de spil jeg spiller, så køber jeg ny CPU (med øjnene og den sidste tålmodighed kastet efter Ryzen 7000 eller evt. 13. gen Raptor Lake) - Men den gamle CPU skal først have lov at få chancen, da den hidtil altid direkte har MOST mit nuværende 3080 i 4K (Jeg tror faktisk det bliver dens 4 GPU makker denne gang?), som dermed har vist sig at være den endog helt store flaskehals i mit setup - jeg gider naturligvis ikke bruge penge på at opgradere CPU før det reelt viser sig relevant for mig og min situation, som det i mit tilfælde, med min nuværende skalering i hvert fald med sikkerhed er mht GPU, idet 3080 udgør den HELT store bottleneck for mig i alt jeg har spillet hidtil. Det CPU'en så i øvrigt skulle kunne følge med til hos mig er 120 hz og med DLSS 3 skal dette oven i købes som sagt regnes som mindre endnu - Så jeg får se hvor det lander - Det vil alt sammen vise sig og så handler jeg - eller lader være - på basis af hvorda det nu falder ud. F.eks. kan jeg jo faktisk notere mig at trenden går mod større og større CPU anbefalinger på de allernyeste PC-spil der er current-gen only mht konsollerne, da PS5 og Xbox Series X jo har fået relativt kompetente CPU'er denne gang og multiplatformtitler derfor også designes efter det. Så ja, lånt tid, ja bestemt! Men nu ser jeg lige hvordan det lander med min nuværende CPU og så giver jeg også lige Ryzen 7000 (som jo ser lovende ud) eller 13. gen Raptor Lake tid til at lande først før der alligevel er interessant, hvis det viser sig at CPU opgradering bliver relevant. Og ja, havde jeg spillet 1440p, for slet ikke at nævne 1080p, så havde pipen naturligvis haft en HELT anden lyd. Redigeret af TBC1 - 28-September-2022 kl. 11:53 |

|||||||

|

PC:9800X3D,RTX 5090 OC,32GB DDR5@6K-CL30,48" LG CX

Stue:JVC N7,StudioTek 130,Denon AVR4308,Bladelius Ymer,B&W 803D,SVS PB16-Ultra,DMR-UBC80,Shield 2019 Sovevær.:77" S92C,HTP-075,ATV4K |

|||||||

|

|||||||

Lort

Ny bruger

Oprettet: 26-September-2022 Status: Offline Point: 8 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 27-September-2022 kl. 13:18 Sendt: 27-September-2022 kl. 13:18 |

||||||

|

Jeg ved ikke helt hvad du mener med "gamle rasterization titler" - langt de fleste spil i dag kører folk uden Ray Tracing og det er også få spil der faktisk har det, når man kigger på alle spil der udkommer.

Derudover er der endnu længere mellem de RTX titler hvor det faktisk gør en forskel. Nvidia har presset på med udbredelsen af RTX features og mange spil som har RTX elementer indbygget føles bare rushed og/eller ikke værd at bruge. Nvidia betaler oftest udviklerne for at smide det i. De gør det ikke gratis. Der bruger udviklerne nærmere AMDs FSR og deres Fidelity FX Suite som er meget nemmere at implementere og virker for alle. FSR har f.eks. hurtigere vundet indpas end DLSS, uden at AMD har måttet betale udviklerne og selv Nvidia GPUer kan bruge det, ja selv dem med GTX kort fra 900 og 1000 serien. Jeg har spillet mange spil med RTX features, men ofte er det ikke blevet brugt alligevel fordi det ikke gør en stor forskel, især ray tracing. Nogle gange ser det endda værre ud eller irriterer. Der har været spil hvor alle flader har lignet et spejl f.eks. Ting som DLAA og DSR (Tensor) har imponeret mig mere end decideret Ray Tracing. Personligt synes jeg ikke det gør en stor nok forskel til at det er værd at bruge, for man bemærker knap nok forskellen når man faktisk sidder og spiller. Det er mest hvis man bare står stille og kigger rundt og virkeligt kigger efter at man ser hvad det kan, men fps hit er så stort at det ikke er værd at bruge når man spiller spillet som det burde spilles. Jeg vil til enhver tid foretrække 120-180 fps fremfor 60-90 med Ray Tracing. Derudover er der små hak til tider (i nogle spil) når ray tracing bruges, der er mange artikler om det, som om at selve GPUen venter på Tensor udregninger efter noget tid. Det kan se virkeligt godt ud på screenshots osv, især når man cherrypicker områder i spil, men når man faktisk sidder og bruger det selv, i et spil man sjovt nok prøver at spille (bevæger sig hurtigt rundt), så er det knap så wow og man mister nærmest intet i forhold til dem der ikke bruger det. DLSS 3.0 er slet ikke testet i dybden som DLSS 2.0 efterhåndne er. DLSS 3.0 laver hele frames ud fra AI/beregninger som ikke eksisterer til at begynde med. Det lyder til at give blur/smearing, som de tidligere DLSS udgaver også har lidt af i større eller mindre grad, afhængig af spil og implementeringen heraf. At fylde pixels ud med hjælp fra AI/Tensor cores er noget andet end at lave HELE FRAMES ud fra AI. Har selv spillet Cyberpunk på omkring maksimum i 4K/UHD på mit OLED TV med 120 fps uden RT og RT blev testet mange gange, men aldrig værd at bruge. Havde jeg kunne få præcis samme fps med RT, så var det måske værd at bruge, men det vil altid være en dyr affære og det tilføjer også ofte yderligere latency og endda stuttering, når det bruges, da spillet til tider kan vente på tensor/AI færdiggøre beregningerne. 3090 Ti er 8-10% hurtigere end 3090 i 4K/UHD og det var meget mindre end 11% cutdown. 3090 Ti havde kun 256 cores mere end 3090. Det er 2.5% mere. 4090 Ti tegner til at få ~2000 flere kerner end 4090 + De hurtigere ram. Tror nærmere 4090 Ti bliver 12-15% hurtigere, hvis ikke mere. Men ja jeg ville da nok heller ikke vente et år, men det behøves nu heller ikke være et år hvis AMDs løsninger bliver gode, så er Nvidia's eneste mulighed at smide et 4090 Ti ud hurtigst muligt og Radeon 7000 release er meget snart. Du kan være helt sikker på at den 7700K holder et 4090 tilbage, ja selv et 3080 vil blive holdt tilbage. Utallige spil i dag har slet ikke nok i 4 kerner. Selvom man kører høj opløsning, kræver det at CPU kan fodre GPU hurtigt nok. 7700K yder nærmest identisk med en 6700K og vi snakker 8 år gammel teknologi. Det er slet ikke nok til high-end GPUer i dag, uanset om du kører 4K/UHD eller ej, især ikke hvis du bruger Ray Tracing. Der skal være balance i et system. Et grafikort til 16.000 og en CPU som 7700K som måske koster 300 kroner brugt i dag giver ingen mening. Det absolut mindste jeg ville bruge til et high-end kort i Ampere eller Ada er i7-8700K eller Ryzen 5600X. Du har ikke engang PCIe 4.0 i det system og du kan heller ikke bruge Resizable BAR. Alt i alt kigger du ind i et stort tab i ydelse ved at bruge så gammel en platform til et nyt kort og det vil med garanti være HELT SLUT for en 4 kerners CPU meget snart, da de første next gen spil er på trapperne som udelader ps4/xbox one support og er udviklet og optimeret til 8 relativt hurtige kerner som ps5 og xbox series x har. En højt clocket 6 kerners cpu med ht/smt vil nok stadig gøre det fint, men det vil være det sidste søm i kisten for 4 kerners CPUer. I Cyberpunk er der kæmpe forskel på 4 kerner og 8 kerner. Der er utallige videoer og tests som viser forskellen. Selv i et 10 år gammel spil som Crysis 3 er der stor forskel på 4 og 6 kerner. 4090 med 7700K svarer i bund og grund til at sætte de absolut dyreste dæk du kan finde, på en gammel rusten skoda city go. Det giver ingen mening. Et high-end grafikkort kræver en high-end platform og cpu + ram for at yde optimalt. Jeg ville hellere opgradere platformen og nøjes med et 4080. Jeg har selv 1440p IPS 300 Hz på min PC men også mulighed for at smide det over på 4K/UHD med OLED/120 Hz/Gsync hvis jeg spiller en type spil, der egner sig bedre til det. Typisk bruges der også controller når jeg gør det. Jeg nægter at tro du har fået max GPU usage i alle spil selv med et 3080. For der er utallige spil på markedet i dag hvor de faktisk anbefaler 6+ kerner. Det betyder at grafikkortet vil blive holdt tilbage og du vil opleve at det hakker (lav minimum fps). Jeg spiller alle mulige spil, ved ikke med dig, men at regne med at alle spil får DLSS 3.0 ville jeg ikke sætte min opsparing på. Der er MANGE spil som aldrig fik eller får DLSS 2.x og implementeringen svinger meget fra spil til spil. I nogle spil er det slet ikke værd at bruge, tænker det bliver præcist det samme med DLSS 3.0 og de fake frames man får. Det kommer sikkert til at give smearing-lignende billedekvalitet, med ghosting som mange DLSS/FSR spil også allerede lider af, men HER er det kun nogle pixels som bliver udregnet, med DLSS 3.0 bliver det HELE FRAMES som er udregnet. Det lyder nærmest som motion interpolation på TV hvor den også skaber frames som i bund og grund ikke eksisterer. Du kan heller ikke regne med Nvidia's egne slides når det kommer til performance udenfor RT spil, da de med 100% sikkerhed har udplukket de spil hvor der er størst forskel. Jeg vil vædde med at når de første reviews af 4090 lander så er virkeligheden en helt anden. MEN ja du kan da prøve med 7700K men jeg vil råde dig til at prøve at få testet kortet i en række spil i dit eget system og så i et med meget nyere CPU og RAM og jeg vil garantere at du vil opleve et stort løft i overall ydelse, især i minimum fps, da CPUen ikke kvæles mere. Vi snakker i nyere AAA spil her, ikke ældre spil. Men da du snakker om RT spil, så tænker jeg også at det er de store AAA titler du mener, da det er dem Nvidia for det meste går efter at få RTX features i. Forresten så hæver DLSS 3.0 latency (input delay på mus/tastatur) da de frames du får, faktisk ikke eksisterer i praksis, men er beregnet. Det er noget HELT ANDET end måden DLSS 1-2.x og FSR 1-2.x fungerer på og det virker nærmest som en måde at booste performance på papiret på. Jeg er 100% sikker på at INGEN der spiller seriøst/competitive spil nogensinde vil bruge det, da man ser fake frames og at Nvidia bruger DLSS 3.0 i deres sammenligning virker meget suspekt og i mine øjne et stort "red flag" Det giver ingen mening at bruge DLSS 3.0 på 4000 serien til at sammenligne med noget som helst tidligere, da fake frames står for en god slat af den ydelse Nvidia snakker om. Slet ikke brugbart for mange mennesker og heller ikke muligt at bruge i ret mange spil. Jeg prøver ikke at tale 4000 serien ned, men glæder mig til ikke-biased reviews. Jeg stoler ALDRIG på fps sammenlininger fra Nvidia, AMD eller Intel selv. De vil ALTID vælge best case og det faktum at Nvidia var tvunget til at tage DLSS 3.0 i brug for at få 4000 serien til at fremstå bedre gør det ikke ligefrem mere pålideligt. Jeg er meget skeptisk ved DLSS 3.0 indtil det er testet til bunds. Det virker lidt som snyd. Lidt ligesom måden Intel bruger effiency cores på at booste MP performance i syntetiske benchmarks, hvor mange programmer i bund og grund slet ikke rører de kerner, men holder sig til performance cores, eller helt tager fejl af cores, som var et stort problem da Alder Lake først udkom og stadig kan ske. Der er i mine øjne kæmpe forskel på at beregne *nogle* pixels til en frame og så til at genskabe en helt frame som ikke eksisterer til at begynde med.

Redigeret af Lort - 27-September-2022 kl. 14:40 |

|||||||

|

|||||||

TBC1

Guld medlem

Oprettet: 19-Februar-2009 Status: Offline Point: 2053 |

Funktioner Funktioner

Tak(0) Tak(0)

Citér Citér  Svar Svar

Sendt: 27-September-2022 kl. 21:04 Sendt: 27-September-2022 kl. 21:04 |

||||||

|

3090 Ti var hurtigere end 3090 ud over forskellen i cut down, fordi 3090 Ti bedre chipsamples fik højere TDP og højere clockfrekvenser. Så det er der for så vidt ikke noget overraskende ved. Et 4090 Ti har efter alt at dømme potentiale til at blive ENDNU kraftigere, altså ud over forskellen i cut-down, da headroom ser ud til at være ENDNU større mht TDP og clockfrekvenser denne gang end den var i sidste generation med Samsungs chips. Det er allerede hintet fra Nvidia selv at de kommende 4090 er meget overclockable til over 3000 Mhz og vi har jo også alle hørt rygterne om hvad der er muligt hvad angår TDP's, så ja, et RTX 4090 Ti kan blive et rigtigt high-end monster. Men vil jeg have brug for det til en 4K@120 fps skærm? Ville det være værd at vente på ifht RTX 4090? Viser det sig at være tilfældet, så kan RTX 4090 jo nok stadig sælges når RTX 4090 Ti udkommer, hvis TI viser sig merprisen værd ;-)

Mht skalering, må du så selv tro hvad du vil, men mine problemer har så godt som altid været et maxed out RTX 3080. Der er jo også en verden eller to til forskel på 1440p@300 fps og max out settings til 4K@120 fps i forhold til hvor flaskehalse hurtigts opstår. Mht spil, spiller jeg stort set kun single-player games, ikke f.eks. MMORPG's, da jeg ikke har tiden og overskudet til at involvere og forpligte mig i forhold til venner, klaner mv. Tak for bekymringerne, men du behøver altså ikke at være urolig på mine vegne som du lyder til at være. Jeg spiller altid med en formindsket Rivatuner Statistics Server status for CPU, GPU og FPS åbent oppe i hjørnet, så jeg altid kan holde øje med hvad der forgår når jeg spiller og hvor en flaskehals opstår. Og det har endnu ikke været hverken Resizable BAR eller PCI-e version (som reviews har vist ind til videre har betydet uendeligt lidt, men UE5 og overgangen til større vægt på streaming via brug af Windows Direct Storage mv. kan så måske komme til at ændre radikalt på det, selv om RTX IO båndbredden, selv med ældre PCI-e generationer bliver større end den IO båndbredde der er i PS5). Når jeg begynder at opleve en større vægt af problemer andre steder end GPU, som jeg bestemt risikerer nu hvor jeg opgraderer til et RTX 4090, og hvis jeg så får mindre ydelse ELLER stabilitet end jeg vil acceptere på grund af CPU, så kommer jeg også til at handle på det, fuldstændigt som hidtil: Enten ved at gemme spillet til efter en opgradering (som jeg f.eks. aktuelt har gjort med Cyberpunk 2077 og Spiderman Remastered, hvor jeg også regnede min CPU for lille fra reviews af spillet) eller ved at trykke på opgraderingsknappen igen, ganske som jeg også gør nu i forhold til min aktuelt absolut største flaskehals: GPU'en. Jeg mente ellers at jeg selv havde fremhævet det selv ganske tydeligt i hvad jeg selv skrev ovenstående om at jeg netop havde noteret mig, at "trenden går mod større og større CPU anbefalinger på de allernyeste PC-spil der er current-gen only mht konsollerne, da PS5 og Xbox Series X jo har fået relativt kompetente CPU'er denne gang og multiplatformtitler derfor også designes efter det og jeg dermed VED at jeg lever på lånt tid" (citat slut), så ja, vi er rørende enige om hvad du skriver om next gen spil, selv om jeg er begyndt at kalde seneste konsolgenerationen for current-gen (mens titlerne der alene eksisterer på den generation kun i det meget små er begyndt at minifestere sig). Det er jo ikke tilfældigt at jeg siger at jeg ved at jeg lever på lånt tid mht CPU. F.eks. har jeg udskudt Spiderman remastered, da det fra reviews af det stod klart at hverken min nuværende GPU eller CPU kunne kreditere de settings og den performance ved de settings jeg ønsker mig i det. Den tid jeg planlægger at låne, låner jeg så netop til at hoppe på den CPU generation der er lige om hjørnet, da det for mig virker kontraindiceret at opgradere lige før en ny generation lander, som lader til at bringe en del ekstra kræfter til bordet. I mellemtiden vil jeg så spille titler hvor CPU'en ikke kommer til at holde mig tilbage fra at opnå de 4K@120 fps jeg sigter efter ved maxed out grafiske settings - og dem er det fortsat et stor portion af inden for 1-player spil. Mht RayTracing, så betyder det fra dine udsagn åbenlyst langt mere for mig end det gør for dig - Det lyder til at vores præferencer slet og ret bare er ret forskellige, med hensyn til både RayTracing og AI aspekterne og hvad de muliggør og facilliterer. Metro Exodus enhanced edition er uden sammenligning det lysmæssigt mest imponerende og mest stemningsfyldte spil jeg nogensinde har spillet, jeg nød og værdsatte det i fulde drag - Det var den første AAA titel med hvad jeg forstår som ÆGTE Raytracing, altså hvor alt lys på globalt niveau ene og alene er baseret på RayTracing unden brug af kunstigt baked-in-lys. Cyberpunk 2077 lader så til at blive det andet AAA spil vi får at se af den slags, med hvad jeg har forstået om det CD Projekt Red kalder "RT overdrive". DLSS gav mig bedre visuel kvalitet end native 4K render i f.eks. Death Stranding - Det sad jeg og spillede det på stuens 123 tommer under Coronakrisen. Jeg er også meget glad for at benytte DL-DSR, som i den grad også øger den visuelle kvalitet på en store 4K skærme uden samme FPS penalty som almindelig DSR. Jeg er ikke som dig så nervøs for DLSS 3's frame creation, for DLSS er fra start bygget op omkring analyse af bl.a. både motion vectors og temporale billedaspekter, så den temporale opskalering der nu tilføjes, er som jeg ser det, kun en helt naturlig evolution af teknologien og dens potentialer. Så nej, jeg ser ikke en kæmpe forskel på at beregne størstedelen af de pixels der ikke i forvejen eksisterede i en frame fra bl.a. temporale aspekter og motion vectors og så at beregne en frame der ikke i forvejen eksisterede fra bl.a. nøjagtigt de samme basis elementer; herunder motion vectors og de temporale aspekter der således danner basis for begge dimensioners opskaleringsforbedringer. Det er lidt 2 sider af samme mønt. Ser man analytisk på sagen angående hvad der reelt findes at kunne opskalere, så handler det jo om, at de aspekter hvor man kan forbedre opløsningen udgøres af den spatiale og den temporale opløsning. DLSS 1+2 forbedrede den spatiale opløsning (og AA) og DLSS 3 kommer så til at forbedre den temporale opløsning oven på dette allerede eksisterende aspekt. Begge dele vil komme til at bidrage positivt - Det er jeg slet ikke i tvivl om og det er Digital Foundry åbenlyst heller ikke. De grunde der er til at jeg ikke er nervøs er (1) at Digital Foundry allerede i de 2 hidtidige videoer om emnet (den seneste fra i går + teaser-traileren om de kommende analyservideoer) har afsløret at resultatet samlet set er rigtigt godt - de er allerede i fuld gang med at dybdeanalysere det mht til både styrker og svagheder. De har også allerede både omtalt og i det små fremvist at artifakterne [der som med DLSS 2's spatiale opskalering vil være der i en eller anden udstrækning hvis man jagter og leder grundigt nok efter dem] er MARKANT mindre end 2D baserede temporale opskaleringer, som kendt fra TV, off-line AI baserede spatiale og temporale opskaleringsprogrammer mv, da DLSS 3 jo (og det er så grund nr. 2) har den luksus at kunne gøre brug af en game-engines eksisterende 3D informationer angående bl.a. motion-vectors og at kunne kombinere motion vectors med opical flow analyse samt udnytte data fra color-buffers og z-buffers indeholdende 3D dybdeinformationerne og informationerne om objekternes indbyrdes placeringer og bevægelser mv. i spillets 3D rum. Det er forhold som egentlige/regulære video opskalerings algoritmer til spatial og temporal opskalering IKKE har at gøre godt med, selv ikke de tungeste off-line versioner kan drømme og så begunstigede data at bygge arbejdet på som fundament. Så DLSS 3's framecreation er med andre ord ikke bare at regne som lige med eller identisk til den video motion interpolation vi kender fra TV, eller for den sags skyld off-line AI video opscalere, men noget der er begunstiget med game engine data som fundament til at kunne arbejde ud fra på dette fundaments højere niveau, med en sådan direkte tilkobning til en game-engines informationer. (3) Jeg er bekendt med hvordan det menneskelige syn fungerer og hvad der overhovedet opfattes "live" af artifakter mens FPS'ene flyder, særligt ved høje framerates og (4) artifacts i DLSS er dårligt synlige selv ved slow-motion, i f.eks. den halve hastighed Digital Foundry har fremvist angående 120 fps DLSS 3 og end ikke i andre eksempler hvor nogle har lavet en 12 x slowed downed video af Cyberpunk 2077 med DLSS 3 fra hvad der nu ligger i 60 fps på YouTube af det - selv om det så naturligvis ikke er et lige så godt et analysemateriale i forhold til hvad Digital Foundry laver direkte med kortene, så ser det stadig meget lovende ud og artifacts er noget man virkelig skal spejde efter at finde. (5) Jeg kender resultaterne fra tunge-off line AI opskalere der kan tage en hel nat for temporalt opskalere bare 3½ minuts musikvideo på mit eksisterende RTX 3080. Da disse ikke har den luksus beskrevet i "2" introducerer sådanne spatiale og temporale opskalere markant større artifacts end man ser fra DLSS 3, men grundet det menneskelige syn er det stadig, hvis kurateret ordentligt, i stand til at formidle den større spatiale og temporale opløsning der samlet set giver et resultat langt bedre end hvad der har været opskaleret fra og som er i en helt andel liga end hvad der er kendt fra f.eks TV's udsmattede elendige on-the-fly frame interpolation (som DLSS 3, som koblet på game-engine 3D rum og bevægelsesdata, som forklaret ikke er identisk med) Men allerede her er tunge off-line resultater tættere på ægte HFR kilder end på TV's motion interpolation. Og DLSS 3 vil som sagt være bedre stillede med tilkoblinger til game-engine data og dermed kunne give bedre resultater end sådanne, grundet de flere basis-elementer DLSS 3 har at gøre godt med som luksus (jævnfør igen grund 2). (6) Flere fps i netop computerspil fucker ikke med mere uplastiske hjerners tilvænning til 24 fps filmmateriale som det sker for nogle uheldig mht HFR i film (som jeg personligt er stor fan af) - Dette vil ikke være tilfældet og slet ikke et issue for computerspil, tværtimod vil de flere frames udelukkende opleves som befordrende. Så der er også på det punkt igen tale om en sammenligning der ikke holder, da præmisserne er nogle andre. Jeg siger ikke at DLSS's 3's temporale opskalering bliver 100% perfekt, lige som DLSS 2's spatiale opskalering jo heller ikke er det. Jeg har f.eks. allerede selv spottet i tegn på smearing artifacts i Spiderman Remastered og Racer RTX videoerne fra Nvidia, selv om YouTube's hårde kompression i sig selv smearer og fucker en endnu større dele af videoen op. Men de er der når man ved hvad man kigger efter (det ved jeg fra off-line AI algoritmerne), men er de tilstedeværende i generende eller kompromiterende grad? Nej, det er et rigtigt godt tradeoff for de flere fps man får. Og det er endog ved 60 fps videogengivelse, hvor det kun vil blive endnu mindre synligt ved 120 og ikke mindst 300 fps. Så summa sumarum, lige som med DLSS 2's spatiale aspekter, så forventer jeg fra hvad jeg hidtil har set og ikke mindst hørt fra Digital Foundry, at DLSS 3's temporale aspekter samlet set bliver et gode og lige som med DLSS 2 kommer til at kunne bidrage med hvad der samlet set vil være en bedre oplevelse end der er alene med native rendering - Fuldstændigt lige som med DLSS 2, hvor en opskalering til 4K visuelt kan slå et 4K render. ...Som dig glæder jeg mig også til reviews og ikke mindst at få personlig erfaring med det, men fra hvad jeg allerede ved og har hørt om det, bl.a. fra Digital Foundry, som vel er nogle af de mest analystisk orienterede reviewere man kan finde, så er jeg ikke på samme måde bekymret for det, men spændt på det. Og naturligvis bliver DLSS 3 ikke noget for kompetitive gamere. Men det er hverken FSR 2 og DLSS 2 så heller ikke. DLSS 2 påfører allerede ekstra lantency i forhold til den native renderopløsning der opskaleres fra og FSR tilfører endnu mere latency end DLSS 2. DLSS 3 kommer til at buffere 1 frame ekstra end DLSS 2 og qua obligatorisk brug af reflex til at lægge en ekstra halv frametime til latency, så vidt jeg har forstået det, så det kommer efter alt sandsynlighed til at få en latency der ligger nærmere FSR 2 end DLSS 2 og lige som med disse skal man huske at det også står i relation til den framerate der opereres med (jo højere framerates, jo mindre latency og vice verca - for både FSR og DLSS 2/3). Så, nej det bliver naturligvis IKKE for kompetitive gamere, men efter alt at dømme et stort gode for singleplayer gamere som mig - lige som DLSS 2 allerede er det. Links til nogle af de videoer jeg omtaler: https://youtu.be/qyGWFI1cuZQ https://www.youtube.com/watch?v=lqPF6WJIed8&t=1722s

https://youtu.be/zzbc_fODYso https://youtu.be/spq0jSWRCqI https://youtu.be/AsykNkUMoNU Redigeret af TBC1 - 28-September-2022 kl. 14:37 |

|||||||

|

PC:9800X3D,RTX 5090 OC,32GB DDR5@6K-CL30,48" LG CX

Stue:JVC N7,StudioTek 130,Denon AVR4308,Bladelius Ymer,B&W 803D,SVS PB16-Ultra,DMR-UBC80,Shield 2019 Sovevær.:77" S92C,HTP-075,ATV4K |

|||||||

|

|||||||

Besvar

|

Side <1 2526272829 35> |

| Skift forum | Forum-tilladelser  Du kan ikke oprette nye emner i dette forum Du kan ikke besvare indlæg i dette forum Du kan ikke slette dine indlæg i dette forum Du kan ikke redigere dine indlæg i dette forum Du kan ikke oprette afstemninger i dette forum Du kan ikke stemme i dette forum |